(한국어) AWS Certified AI Practitioner (5) - Amazon Bedrock 모델 평가 가이드

📊 Amazon Bedrock – 모델 평가 가이드

Amazon Bedrock에서 Foundation Model (FM) 을 평가하는 과정은 단순히 성능 확인을 넘어서,

👉 품질 관리, 👉 비즈니스 효과 측정, 👉 편향성(bias) 탐지 를 위해 꼭 필요합니다.

Bedrock은 크게 자동 평가와 사람에 의한 평가 두 가지 방식을 제공하며,

평가 시에는 기술적인 지표(ROUGE, BLEU 등) 와 비즈니스 지표(만족도, 매출 등) 를 함께 고려해야 합니다.

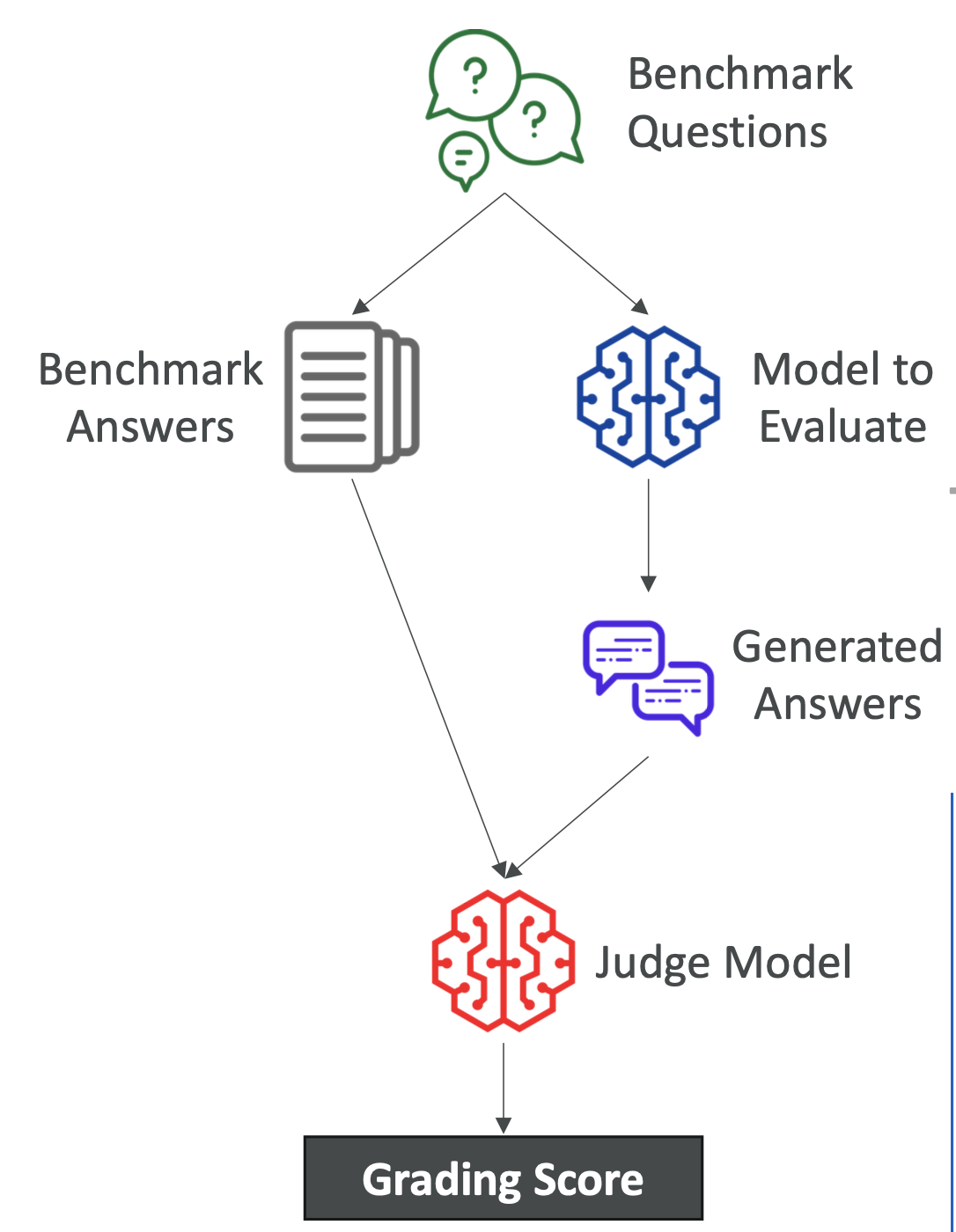

1. 🔄 자동 평가 (Automatic Evaluation)

Bedrock이 직접 모델의 성능을 점수화해주는 방식입니다.

지원되는 기본 과제(Task)

- 텍스트 요약 (Summarization)

- 질문–답변 (Q&A)

- 텍스트 분류 (Classification)

- 자유 텍스트 생성 (Open-ended Generation)

작동 방식

- 평가용 데이터셋 준비

- AWS가 제공하는 벤치마크 데이터 또는 직접 만든 데이터.

- 질문과 ‘정답’(이상적인 답변)을 포함.

- 모델 테스트

- 준비된 질문을 모델에 입력 → 모델이 답변 생성.

- 자동 비교

- ‘심판 모델’이 모델 답변을 정답과 비교 → 점수 산출.

- ROUGE, BLEU, BERTScore 같은 지표 활용.

✅ 장점: 빠르고 일관성 있음, 관리 부담 적음, 편향 탐지 가능.

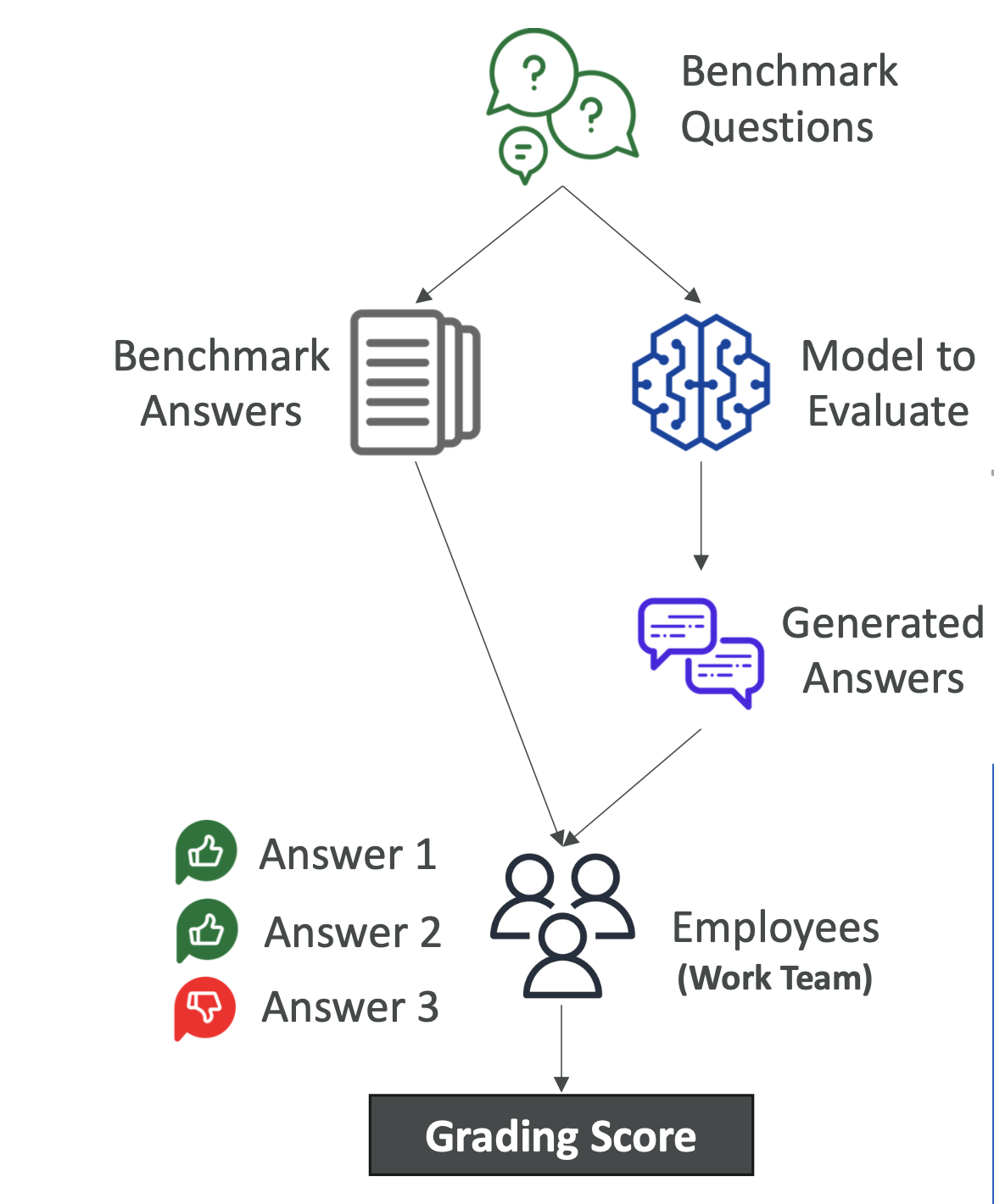

2. 🧑 사람 평가 (Human Evaluation)

사람(내부 직원, 전문가)이 직접 모델의 답변을 보고 평가하는 방식입니다.

평가 방법

- 👍 / 👎 (좋아요/싫어요)

- 여러 답변 순위 매기기

- 별점이나 커스텀 점수 방식

✅ 장점: 기계가 잡아내기 어려운 미묘한 품질 차이나 도메인 특화된 답변 평가에 유리.

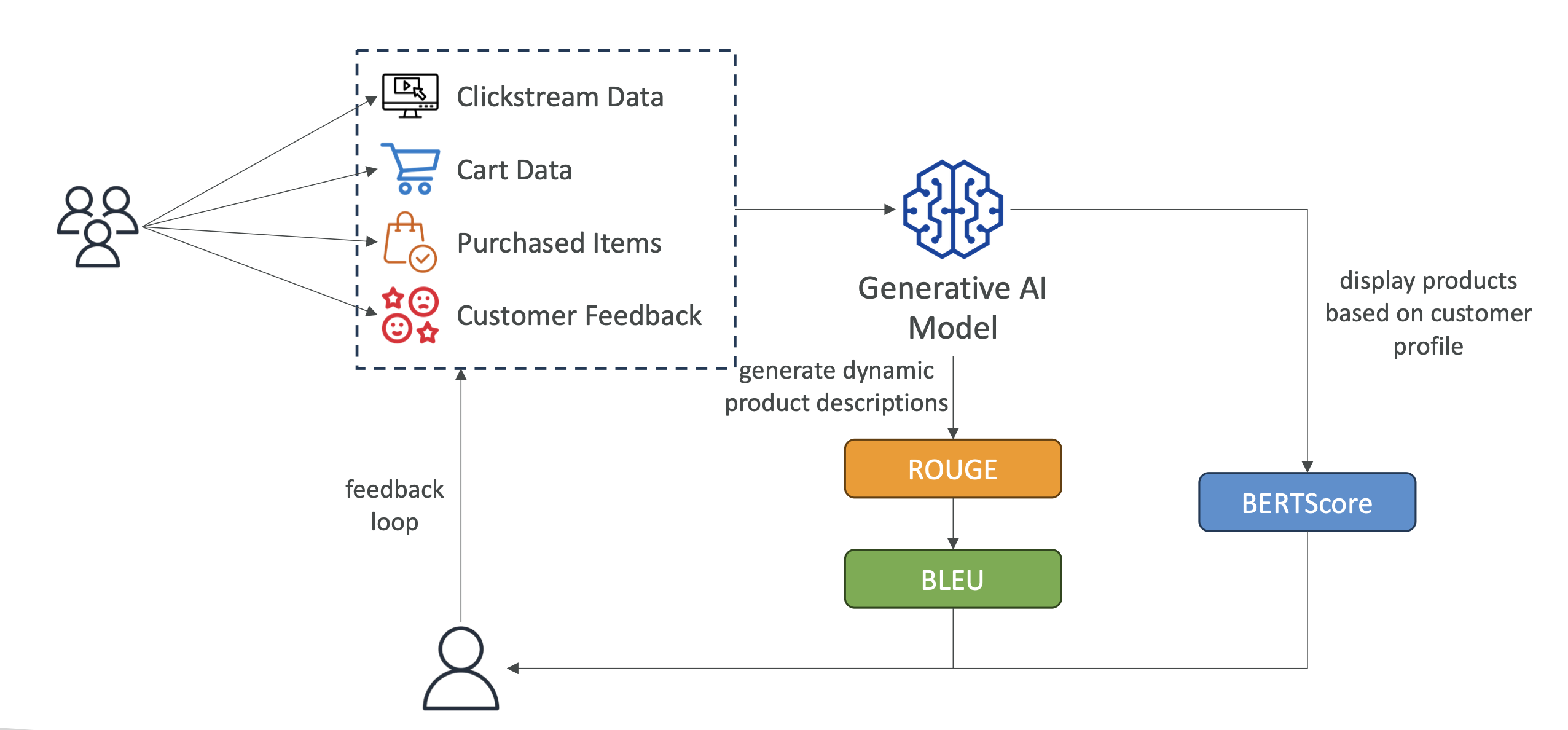

3. 📏 주요 자동 평가 지표

- ROUGE → 생성된 답변과 기준 텍스트 간의 단어/구문 겹치는 정도 (요약 평가에 적합)

- BLEU → 번역 품질 평가 (짧은 답변에 불이익 주지 않음)

- BERTScore → 단순 단어가 아니라 의미(semantic similarity) 기반 비교

- Perplexity → 모델이 다음 단어를 얼마나 잘 예측하는지 (낮을수록 좋음)

📌 시험 포인트: 지표별 특징을 구분해서 외워두는 게 중요합니다.

4. 💼 비즈니스 지표 (Business Metrics)

| 지표 | 의미 | 예시 |

|---|---|---|

| 사용자 만족도 | 모델 결과에 대한 유저 반응 | 챗봇 설문조사 결과 |

| ARPU | 유저 1명당 평균 매출 | 추천 AI 도입 후 매출 증가 |

| 전환율(Conversion) | 행동으로 이어진 비율 | 클릭 → 구매 비율 |

| 효율성 | 인프라 대비 성능 | 비용 줄이면서 정확도 유지 |

시험에서는 기술 지표 + 비즈니스 지표 둘 다 묻는 문제가 자주 나옵니다.

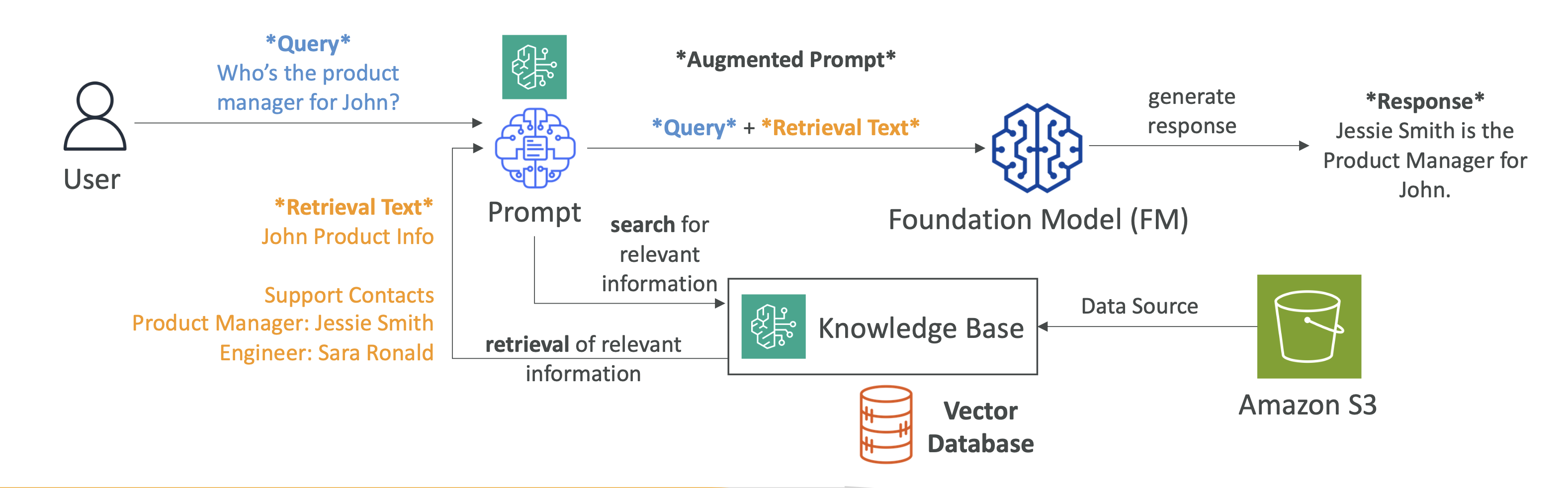

5. 📚 RAG (Retrieval-Augmented Generation) & Knowledge Base

- RAG: 모델이 외부 DB(최신 문서, 데이터베이스 등)에서 필요한 정보를 가져와 답변에 반영하는 방식.

- 동작 흐름:

- 문서를 임베딩(벡터화)

- 벡터 DB에 저장

- 질문 시 관련 데이터 검색

- 검색 결과를 프롬프트에 넣고 모델이 최종 답변 생성

📌 시험에서 “실시간 최신 데이터 반영” → RAG가 정답일 확률 높음.

6. 📝 AWS 자격증 시험에서 중요한 포인트

- ROUGE ↔ Summarization, BLEU ↔ Translation, BERTScore ↔ 의미 비교 구분 필수

- Perplexity 낮을수록 좋은 모델

- Bias(편향) 검출도 평가 목적 중 하나

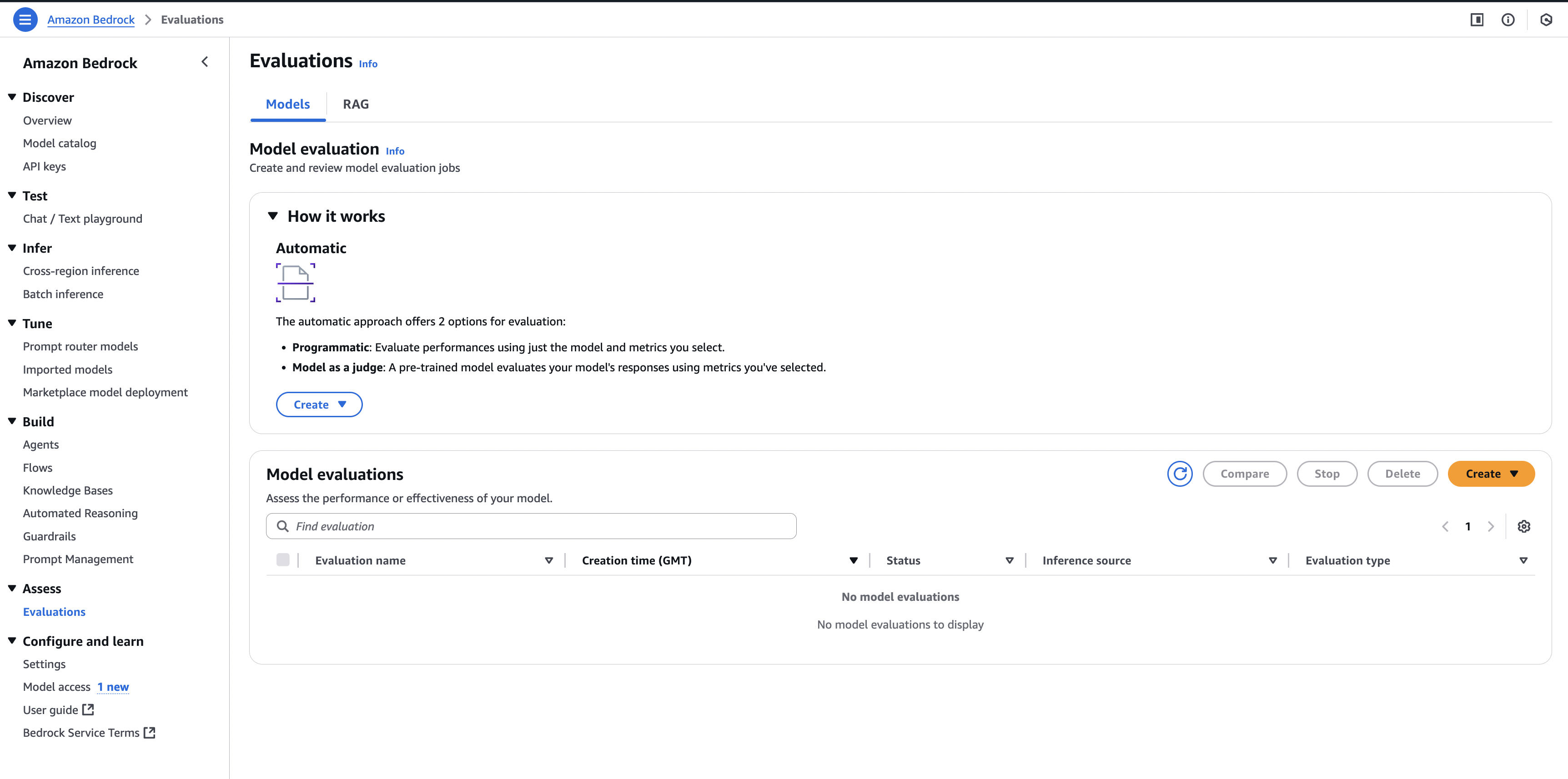

- Bedrock에서 평가(Evaluation) 기능은 콘솔 메뉴에 있음

- Provisioned Throughput (전용 리소스 예약) 개념 자주 출제됨

- RAG = 실시간 데이터 반영 / Fine-tuning = 도메인 특화 학습

7. 🚀 AWS Bedrock에서 실제 평가 방법

콘솔에서 Evaluations 메뉴 클릭

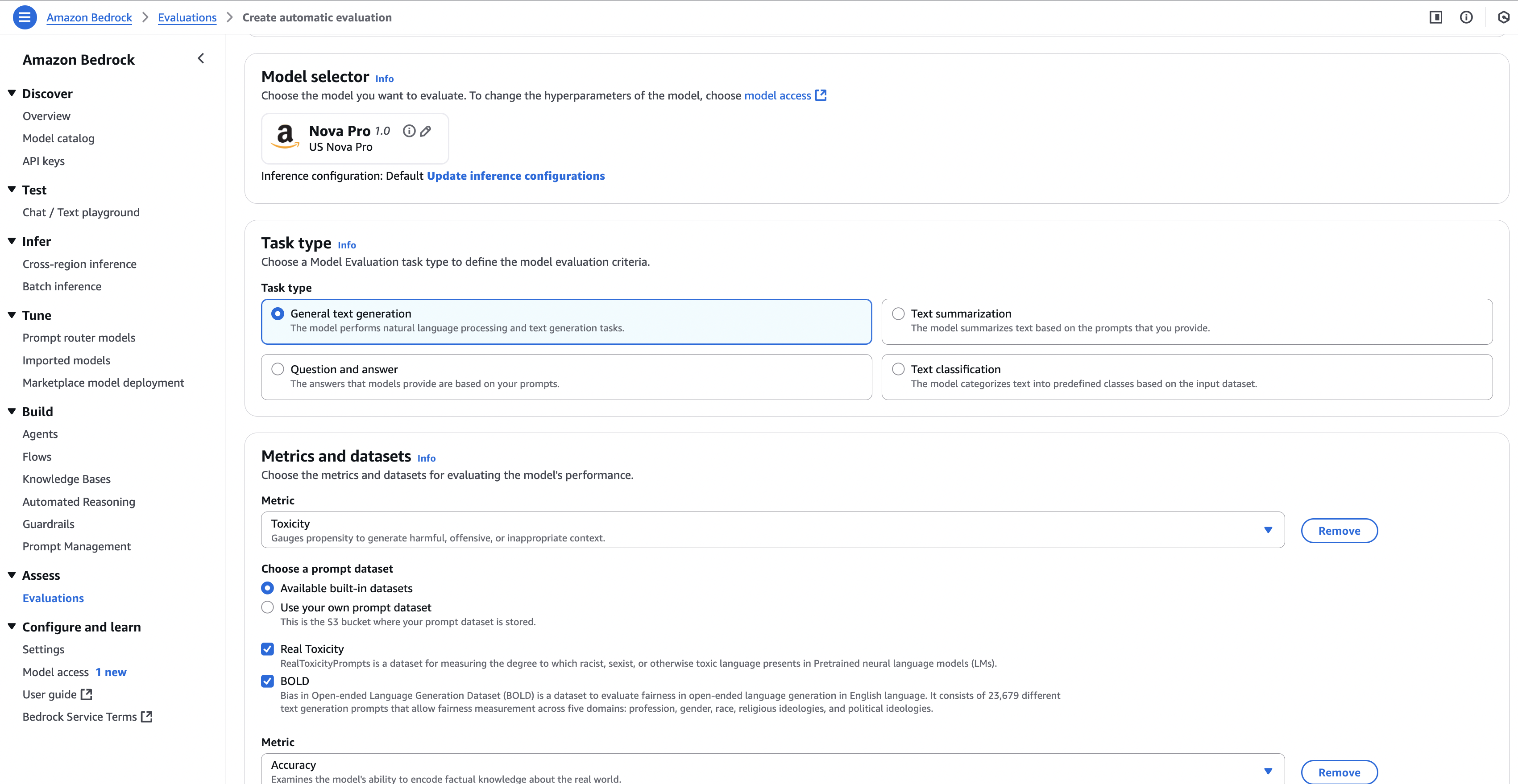

- Create Evaluation → 자동/사람 평가 선택

- 평가할 모델 선택 (여러 개 비교 가능)

- 과제(Task) 유형 선택 (요약, 분류, Q&A 등)

- 데이터셋 선택 (AWS 제공 or 직접 업로드)

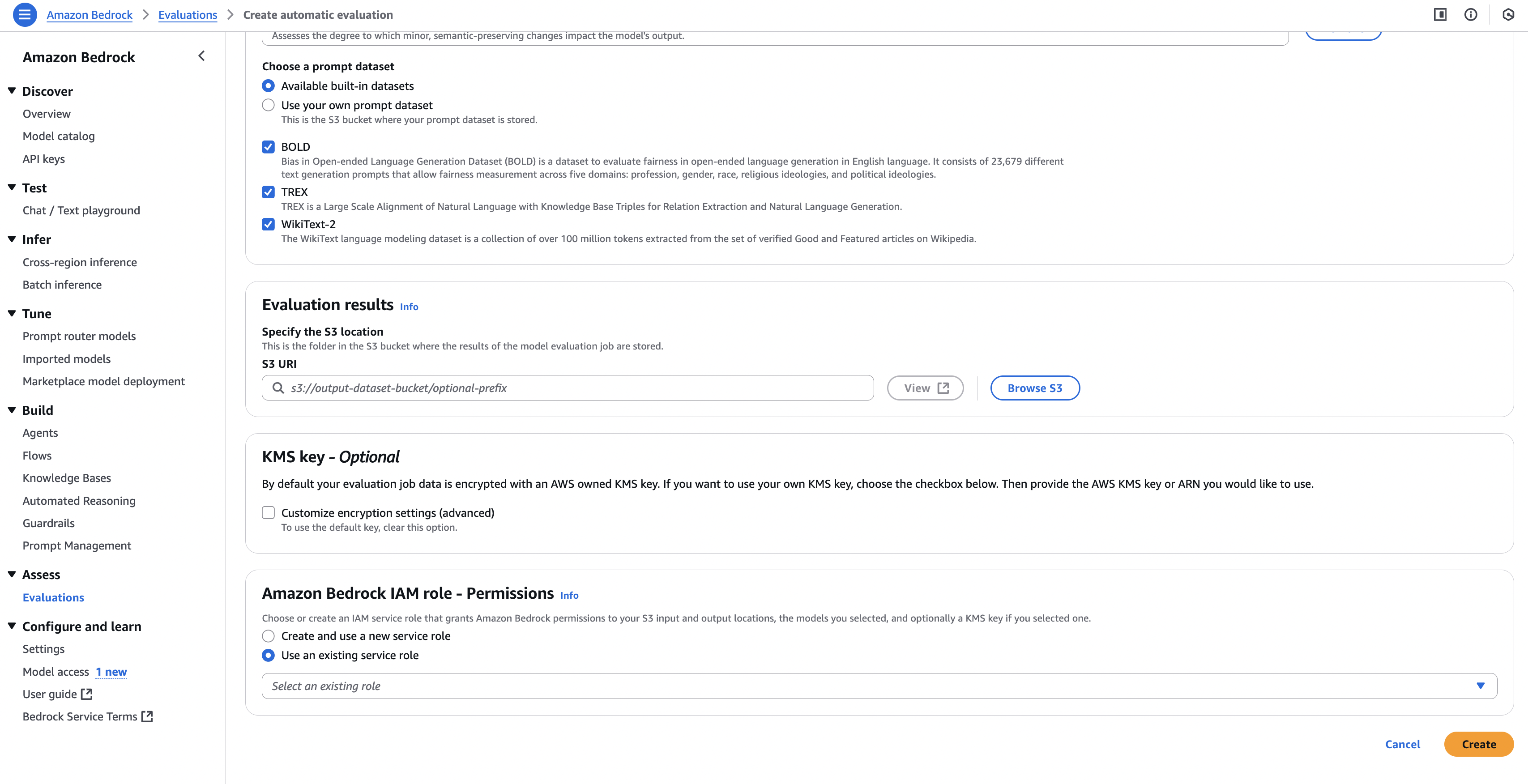

- 평가 지표(ROUGE, BLEU, BERTScore, Perplexity) 선택

- 평가 실행 (Start Evaluation)

- 결과 리포트 확인 (점수 + 예시 답변 + 편향 여부)

📌 시험에서 “어떻게 평가하나요?” → 위 단계를 기억하면 답하기 쉽습니다.

✅ 정리

Amazon Bedrock의 모델 평가는 크게

- 자동 평가 (지표 기반)

- 사람 평가 (주관적 판단)

두 가지로 나뉘며, 실제 프로젝트에서는 비즈니스 지표와 함께 봐야 합니다.

시험에서는 평가 지표의 특징과 RAG, Fine-Tuning, Provisioned Throughput 개념이 자주 출제됩니다.

All articles on this blog are licensed under CC BY-NC-SA 4.0 unless otherwise stated.