(한국어) AWS Certified AI Practitioner (15) - LLM에서 텍스트 생성 과정 & 프롬프트 최적화

📖 LLM에서 텍스트 생성 과정 & 프롬프트 최적화

1️⃣ 텍스트 생성 원리

LLM(대규모 언어 모델)은 다음 단어가 무엇일지 확률적으로 계산해서 문장을 만들어 갑니다.

예를 들어,

“After the rain, the streets were …” 뒤에 올 수 있는 후보 단어와 확률이 있다고 할 때:

- wet (0.40)

- flooded (0.25)

- slippery (0.15)

- empty (0.10)

- muddy (0.05)

모델은 이 확률을 기반으로 무작위 선택(random sampling) 하여 다음 단어를 생성합니다.

즉, LLM의 출력은 항상 확률적이므로, 같은 질문을 여러 번 해도 결과가 조금씩 달라질 수 있습니다.

2️⃣ 프롬프트 성능 최적화 (Prompt Performance Optimization)

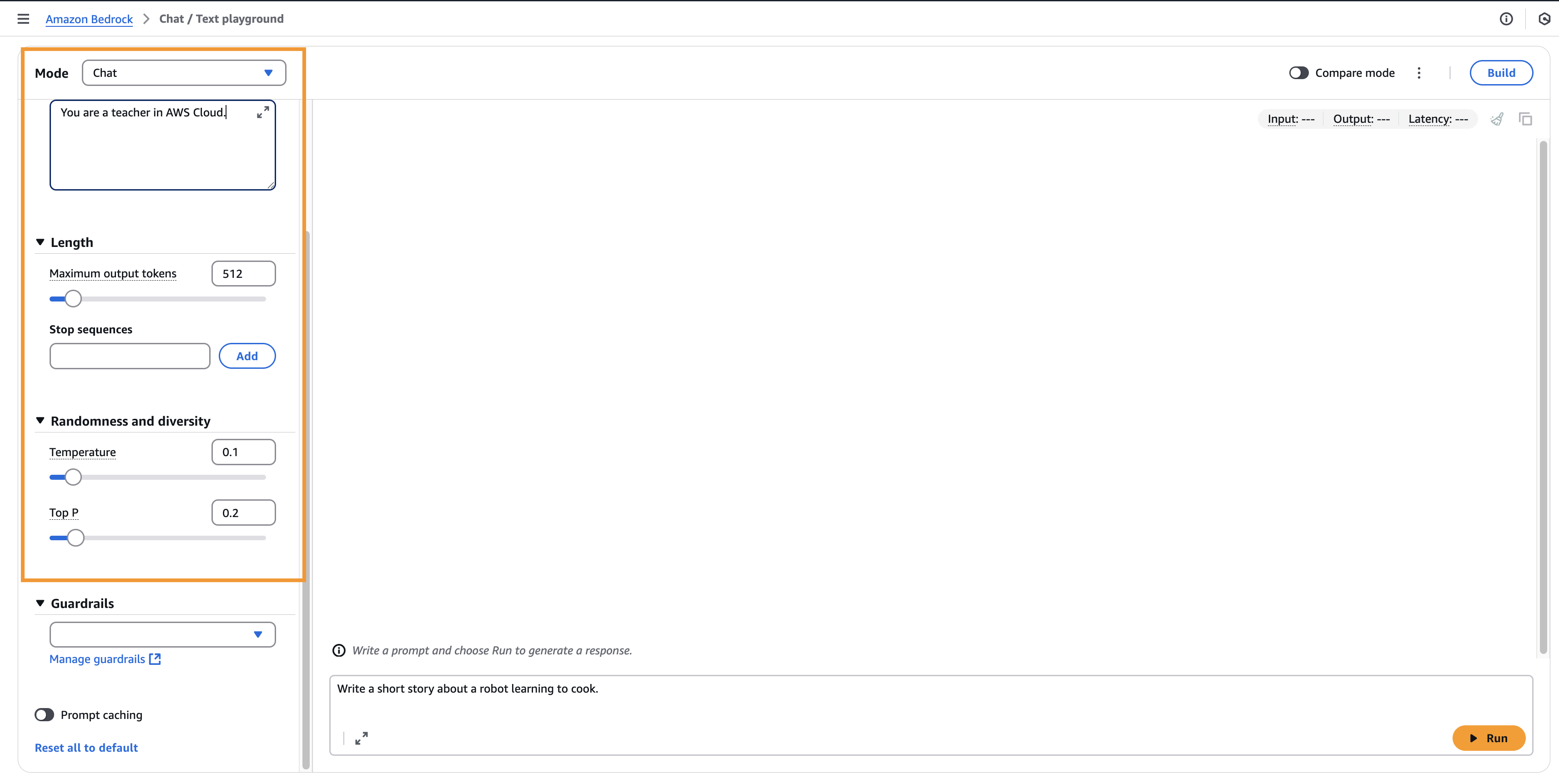

Amazon Bedrock 같은 서비스에서는 출력 품질을 조절할 수 있는 여러 파라미터를 제공합니다.

🔹 System Prompt

- 모델이 어떤 역할을 해야 하는지 미리 정의합니다.

- 예: “너는 AWS 클라우드 선생님처럼 대답해줘.”

- 톤과 답변 스타일을 설정할 수 있어, 일관된 답변을 얻는 데 유용합니다.

🔹 Temperature (0~1)

- 창의성(랜덤성) 조절

- 낮음 (예: 0.2) → 보수적, 반복적, 가장 가능성 높은 답변 선택

- 높음 (예: 1.0) → 다양하고 창의적인 답변, 하지만 가끔은 덜 일관적일 수 있음

👉 시험 포인트: Temperature 값이 낮으면 일관성↑, 높으면 창의성↑

🔹 Top P (Nucleus Sampling)

- 확률 분포 상위 몇 %의 단어만 고려할지 정하는 값

- Low P (0.25) → 상위 25% 단어만 선택 → 더 일관적

- High P (0.99) → 거의 모든 단어 고려 → 더 다양하고 창의적

👉 시험 포인트: Top P는 확률 누적 기준(percentile)

🔹 Top K

- 몇 개의 후보 단어만 고려할지 숫자로 제한

- Low K (10) → 상위 10개 단어만 → 더 예측 가능, 안정적

- High K (500) → 상위 500개 단어 고려 → 더 다양하고 창의적

👉 시험 포인트: Top P는 비율(%), Top K는 개수(N)

🔹 Length

- 생성되는 답변의 최대 길이 제한

🔹 Stop Sequences

- 특정 토큰(문자열)을 만나면 생성을 중단

3️⃣ 프롬프트 지연시간 (Prompt Latency)

Latency = 모델이 응답하는 속도

영향 받는 요소:

- 모델 크기 (큰 모델일수록 느림)

- 모델 종류 (예: LLaMA vs Claude → 성능 차이 있음)

- 입력 토큰 수 (입력이 길면 느려짐)

- 출력 토큰 수 (많이 생성할수록 느려짐)

👉 시험 포인트:

- Latency에 영향을 주지 않는 것: Temperature, Top P, Top K

4️⃣ 정리 표

| 파라미터 | 의미 | 낮은 값 | 높은 값 |

|---|---|---|---|

| System Prompt | 모델의 역할과 톤을 지정 | 동일 | 동일 |

| Temperature | 창의성 | 보수적, 일관적 | 다양, 창의적 |

| Top P | 확률 누적 비율 | 일관성↑ | 창의성↑ |

| Top K | 후보 단어 개수 | 안정적 | 다양, 창의적 |

| Length | 최대 출력 길이 | 짧은 답변 | 긴 답변 |

| Stop Sequences | 생성 중단 조건 | 필요 시 제어 | 필요 시 제어 |

| Latency 영향 요소 | 속도 결정 | 모델 크기, 토큰 수 | 동일 |

| Latency 비영향 요소 | 속도와 무관 | Temp, Top P, Top K | 동일 |

5️⃣ 시험에 자주 나오는 포인트

- Temperature / Top P / Top K 차이점 (시험에서 자주 비교 문제 나옴)

- Latency에 영향을 주는 요소 vs 주지 않는 요소

- System Prompt는 모델의 역할과 톤을 지정할 수 있음

- Length / Stop Sequence는 출력 제어 방법으로 자주 언급됨

👉 요약하자면,

LLM의 텍스트 생성은 확률적 과정이며,

Temperature, Top P, Top K 같은 설정으로 창의성과 일관성을 조절할 수 있습니다.

또한 Latency는 모델 크기와 토큰 수에 따라 달라지지만,

Sampling 관련 파라미터(Temp, Top P, Top K) 에는 영향을 받지 않습니다.

All articles on this blog are licensed under CC BY-NC-SA 4.0 unless otherwise stated.