(한국어) AWS Certified AI Practitioner (30) - 하이퍼파라미터 튜닝

하이퍼파라미터 튜닝 (Hyperparameter Tuning)

1. 하이퍼파라미터란?

- 정의: 모델 구조와 학습 방식을 결정하는 설정값

- 특징:

- 학습이 시작되기 전에 정해짐

- 데이터 자체가 아니라, 학습 알고리즘의 동작 방식에 영향을 줌

- 대표 예시:

- 학습률(Learning rate)

- 배치 크기(Batch size)

- 에포크 수(Number of epochs)

- 정규화(Regularization)

👉 시험 포인트:

하이퍼파라미터는 모델 학습 과정에서 자동으로 학습되는 값이 아니라, 사전에 설정하는 값이다.

2. 하이퍼파라미터 튜닝(Hyperparameter Tuning)

- 목적: 최적의 하이퍼파라미터 값을 찾아 모델 성능을 극대화\

- 효과:

- 정확도 향상

- 과적합(Overfitting) 감소

- 일반화 성능 강화

- 방법:

- Grid Search: 가능한 모든 조합 탐색

- Random Search: 임의의 조합을 탐색

- 자동화 서비스:

- Amazon SageMaker Automatic Model Tuning (AMT) 활용

3. 주요 하이퍼파라미터

(1) 학습률 (Learning Rate)

- 모델 가중치를 얼마나 크게/작게 업데이트할지 결정

- 높은 학습률: 빠른 수렴 가능, 하지만 최적값을 지나칠 위험

- 낮은 학습률: 더 정밀한 수렴 가능, 하지만 속도가 느림

(2) 배치 크기 (Batch Size)

- 한 번의 가중치 업데이트에 사용되는 데이터 샘플 개수

- 작은 배치: 안정적인 학습, 하지만 연산 시간이 오래 걸림

- 큰 배치: 빠른 학습, 하지만 불안정한 업데이트 가능

(3) 에포크 수 (Number of Epochs)

- 전체 학습 데이터를 몇 번 반복해서 학습할지 결정

- 너무 적으면: 학습 부족(Underfitting)

- 너무 많으면: 과적합(Overfitting)

(4) 정규화 (Regularization)

- 모델이 너무 복잡해져 과적합되지 않도록 제어

- 정규화를 높이면 단순해지고, 과적합 방지 효과

👉 시험 포인트:

“과적합을 줄이고 싶다”라는 질문 → 정규화 강화를 정답으로 선택하는 경우가 많음.

4. 과적합(Overfitting)과 해결 방법

- 정의: 학습 데이터에서는 높은 정확도를 보이지만, 새로운 데이터에서는 성능이 급격히 떨어지는 현상

원인

- 학습 데이터가 너무 적음 → 대표성이 부족

- 너무 많은 에포크 학습 → 특정 데이터에만 맞춰짐

- 모델이 지나치게 복잡 → 데이터의 노이즈까지 학습

방지 방법

- 데이터 양 늘리기 (가장 효과적)

- Early Stopping (학습 조기 종료)

- 데이터 증강(Data Augmentation) (다양성 확보)

- 하이퍼파라미터 조정 (학습률, 배치 크기, 정규화 등)

👉 시험 포인트:

과적합 방지의 가장 좋은 답은 보통 데이터 양 늘리기

5. 머신러닝이 적합하지 않은 경우

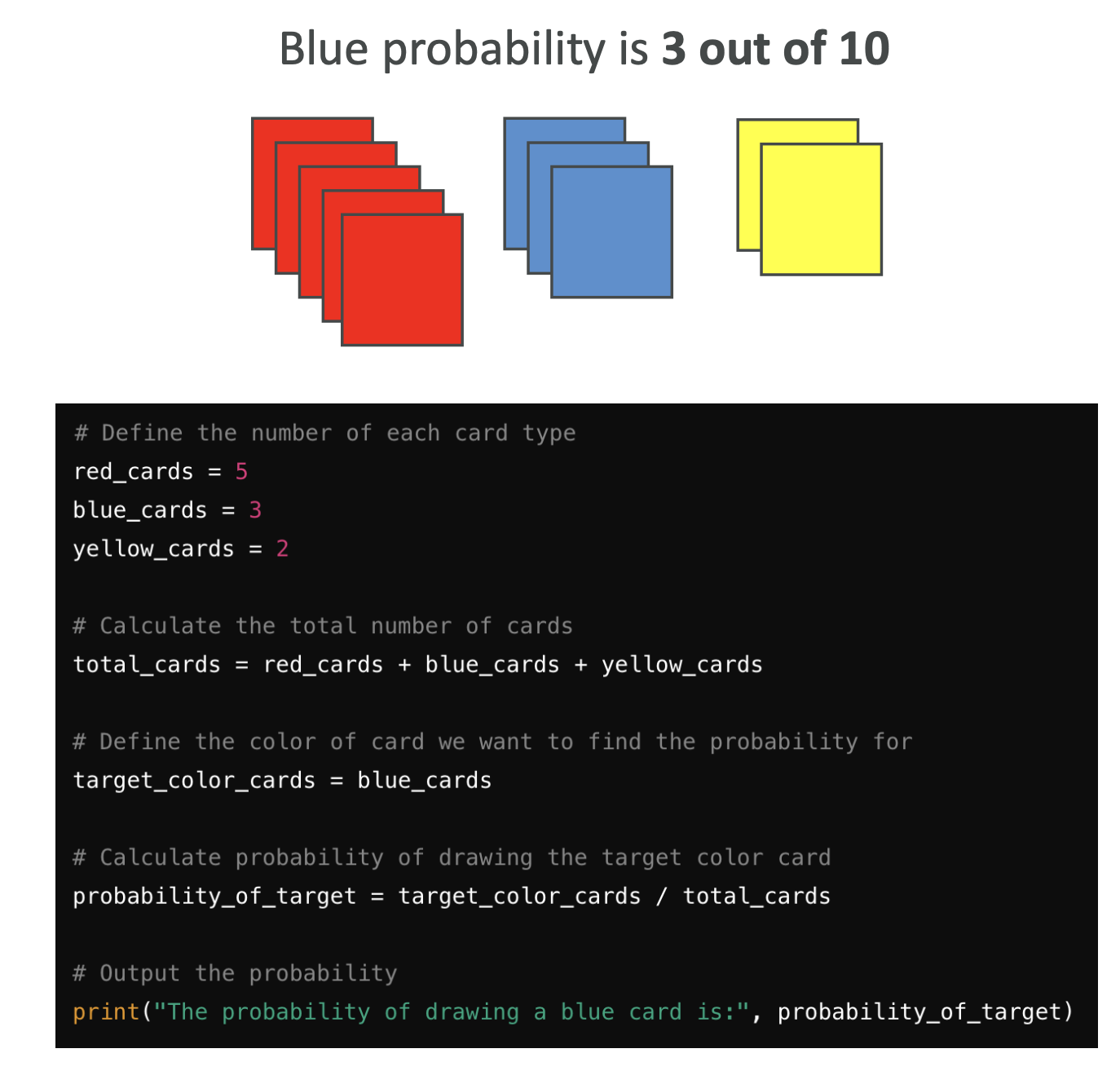

- 예시 문제:

“카드 10장 중 빨강 5장, 파랑 3장, 노랑 2장 → 파랑 카드를 뽑을 확률은?”- 답: 3/10 = 0.3

- 단순 수학적 계산으로 정확히 해결 가능

👉 결론:

- 결정론적(Deterministic) 문제: 코드로 수학적으로 풀 수 있음 → 머신러닝 불필요

- 머신러닝은 항상 **근사값(Approximation)**을 내므로, 이런 문제에서는 적절하지 않음

6. 시험 대비 핵심 요약

- 하이퍼파라미터 = 학습 전 설정 (학습률, 배치 크기, 에포크 수, 정규화)

- 튜닝 목적 = 성능 향상, 과적합 방지

- 과적합 방지 방법 = 데이터 늘리기, Early Stopping, 데이터 증강, 정규화

- AWS 서비스 = SageMaker Automatic Model Tuning

- 머신러닝이 필요 없는 경우 = 답을 명확히 계산할 수 있는 결정론적 문제

👉 요약하면, 시험에서 하이퍼파라미터와 과적합 방지 방법은 반드시 나오는 단골 주제입니다.

특히 SageMaker AMT와 정규화/데이터 증강 관련 문항이 자주 출제됩니다.

All articles on this blog are licensed under CC BY-NC-SA 4.0 unless otherwise stated.