(한국어) AWS Certified AI Practitioner (35) - EC2

Amazon EC2 (Elastic Compute Cloud)

기본 개념

- EC2 = Elastic Compute Cloud → AWS의 대표적인 IaaS (Infrastructure as a Service) 서비스.

- 클라우드에서 가상 서버(인스턴스)를 임대하는 개념.

- EC2를 이해하는 것은 클라우드 기본 개념을 이해하는 데 핵심.

주요 기능

- 가상 서버 임대 (EC2 Instance)

- 스토리지 연결: EBS(Elastic Block Store), EFS, 또는 인스턴스 스토어(하드웨어 기반).

- 로드 밸런싱 (ELB): 여러 서버에 트래픽 분산.

- 오토 스케일링 (ASG): 트래픽 변화에 따라 서버 자동 확장/축소.

EC2 인스턴스 설정 옵션

- 운영체제 (OS): Linux, Windows, macOS 지원.

- CPU: 코어 수와 연산 성능 선택 가능.

- 메모리 (RAM): 애플리케이션 요구사항에 맞게 조정.

- 스토리지:

- 네트워크 연결 스토리지 → EBS, EFS

- 하드웨어 스토리지 → EC2 Instance Store

- 네트워크 설정: 네트워크 카드 속도, 퍼블릭 IP 할당 여부.

- 보안: Security Group(방화벽 역할).

- 부트스트랩 스크립트: 인스턴스 최초 실행 시 자동 실행되는 User Data 스크립트.

👉 시험 포인트

- “EC2 User Data = 인스턴스 최초 실행 시 자동 설정 스크립트”

- “Security Group = 인스턴스 방화벽 규칙”

Amazon EC2와 AI 관련 하드웨어

AI/ML 워크로드에서는 일반 CPU보다 GPU/전용 칩을 활용해야 효율적입니다.

GPU 기반 인스턴스

- P 시리즈 (P3, P4, P5): 고성능 머신러닝/딥러닝 학습용.

- G 시리즈 (G3~G6): 그래픽 처리, 딥러닝 추론, VDI(가상 데스크톱)용.

AWS 전용 AI 칩

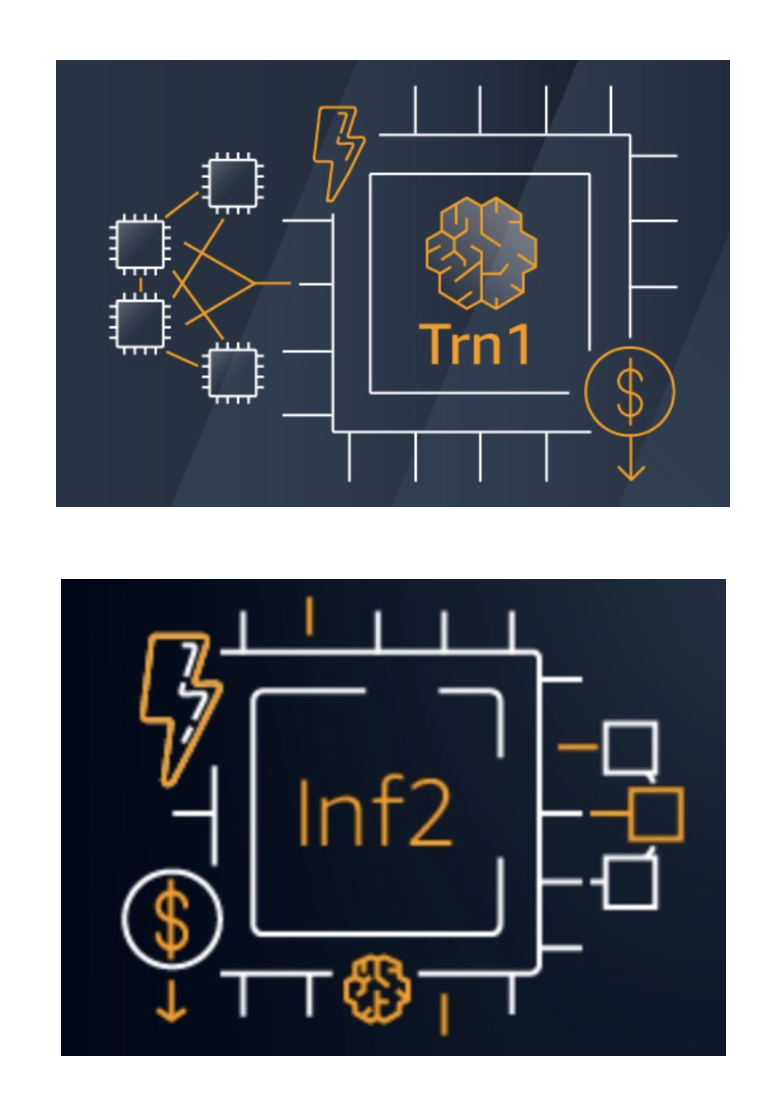

- AWS Trainium (학습 전용)

- 대규모 딥러닝 모델(1000억+ 파라미터) 학습 최적화.

- Trn1 인스턴스: Trainium 칩 16개 포함.

- GPU 대비 최대 50% 비용 절감.

- AWS Inferentia (추론 전용)

- 고성능/저비용 추론(Inference) 가속기.

- Inf1, Inf2 인스턴스에서 사용.

- 최대 4배 처리량, 70% 비용 절감.

👉 시험 포인트

- “모델 학습 최적화, 비용 절감” → Trainium (Trn1)

- “추론 최적화, 비용 절감” → Inferentia (Inf1/Inf2)

- Trainium/Inferentia = AWS 자체 칩, 가장 친환경적(환경 발자국 최소화)

정리 (시험 대비)

- EC2 = 클라우드 가상 서버 (IaaS).

- EBS/EFS: 네트워크 스토리지, Instance Store: 로컬 하드웨어 스토리지.

- ELB: 로드밸런싱, ASG: 자동 확장/축소.

- Security Group: 방화벽, User Data: 초기 설정 스크립트.

- GPU 기반 인스턴스: P, G 시리즈 (ML 학습/추론용).

- Trainium (Trn1): 학습 전용 칩, 비용 절감.

- Inferentia (Inf1/Inf2): 추론 전용 칩, 성능+비용 효율.

All articles on this blog are licensed under CC BY-NC-SA 4.0 unless otherwise stated.